请问下,flinksql读取hive历史数据(十几亿)同步到Oracle中,感觉比较慢,有哪里可以优化的或者其它比较快的导入方式嘛?

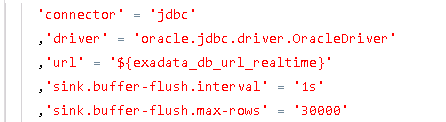

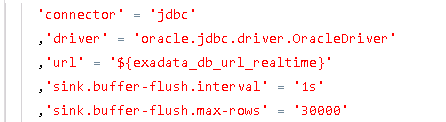

这样设置的

请问下,flinksql读取hive历史数据(十几亿)同步到Oracle中,感觉比较慢,有哪里可以?[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

请问下,flinksql读取hive历史数据(十几亿)同步到Oracle中,感觉比较慢,有哪里可以优化的或者其它比较快的导入方式嘛?

这样设置的

如果您在使用 Flink SQL 将 Hive 历史数据(十几亿)同步到 Oracle 中感觉速度比较慢,可以考虑以下优化方案:

1. 数据分区:对于 Hive 中的数据,可以按照某个字段进行分区。通过在 Flink SQL 中指定需要读取的分区,可以减少读取数据的量,提高读取速度。

2. 并行读取:在读取 Hive 中的数据时,可以使用 Flink 的并行读取功能。将数据分成多个分片并行读取,以充分利用集群资源,提高读取速度。

3. 批量写入:在将数据同步到 Oracle 中时,可以采用批量写入的方式。将多条数据一次性写入 Oracle,以减少写入操作的次数,提高写入速度。

4. 调整并行度:根据集群资源和数据量大小等因素,调整 Flink 任务的并行度。合理配置并行度可以充分利用集群资源,提高任务执行效率。

5. 使用异步 IO:在将数据写入 Oracle 中时,可以考虑使用异步 IO 的方式。将写入操作异步化,以提高写入速度。

6. 配置硬件资源:确保集群中的硬件资源足够满足处理大规模数据的需求。例如,增加计算节点、调整内存配置等。

请注意,在进行优化时,需要综合考虑数据量、集群资源以及任务的执行时间等因素。同时,根据具体情况可能还需要进行更详细的性能分析和调优。

另外,如果您对同步速度有更高的要求,可以考虑使用专门的数据传输工具(如Sqoop或Flume)来将 Hive 数据直接导入到 Oracle 中。这些工具针对大规模数据传输进行了优化,可能会比 Flink SQL 更快速地完成数据同步。

在 Flink SQL 中读取 Hive 历史数据(十几亿)然后同步到 Oracle 中,如果数据量较大,确实可能会比较慢。为了提高同步速度,可以考虑以下几个方面:

数据分区:对于 Hive 中的数据,可以按照某个字段进行分区,将数据划分到多个文件中。在读取数据时,可以指定需要读取的分区,以减少读取数据的量,提高读取速度。

并行读取:在读取 Hive 中的数据时,可以使用 Flink 的并行读取功能,将数据分成多个分片并行读取,以提高读取速度。

批量写入:在将数据同步到 Oracle 中时,可以采用批量写入的方式,将多条数据一次性写入 Oracle,以减少写入操作的次数,提高写入速度。

调整并行度:根据集群资源和数据量大小等因素,调整 Flink 任务的并行度,以充分利用集群资源,提高任务执行效率。

使用异步 IO:在将数据写入 Oracle 中时,可以考虑使用异步 IO 的方式,将写入操作异步化,以提高写入速度。

配置批量入库,我感觉还挺快的,估计是数据量太大了

,此回答整理自钉群“【③群】Apache Flink China社区”