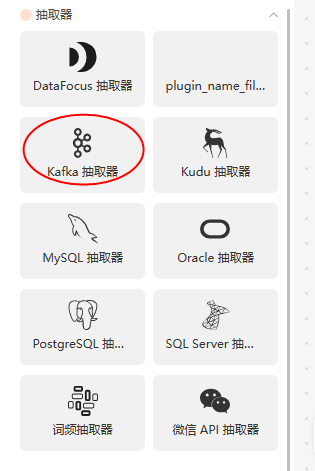

flink支持kafka的cdc吗?不是,我想把kafka作为source,作为mysql那样的源,抽取的源头,读kafka日志,像读binlog一样,应该是不行吧,作为管道用的吧,赛到kakfa我做了一些抽取器,有些支持流,有些不支持流

弄到kafka我就不知道他是支持流还是不支持流,如果说支持流的话,应该有个cdc去连

flink支持kafka的cdc吗?不是,我想把kafka作为source,作为mysql那样的源,[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

是的,Flink 支持使用 Kafka 作为数据源,实现实时数据处理和流式计算。具体来说,你可以使用 Flink 的 Kafka Connector,将 Kafka 作为数据源,实时读取 Kafka 中的数据,并进行实时处理和计算。

与 MySQL CDC 不同的是,Kafka CDC 通常用于从 Kafka 中读取数据,并将数据同步到其他的数据存储系统中,而不是从其他数据存储系统中读取数据。因此,如果你想将 Kafka 作为数据源,可以使用 Flink 的 Kafka Connector,将 Kafka 中的数据读取到 Flink 中,并进行实时处理和计算。

具体来说,你可以使用 Flink 的 Kafka Connector,将 Kafka 中的数据读取到 Flink 的 DataStream 中,然后通过 Flink 的数据处理 API(如 map、filter、reduce 等)对数据进行实时处理和计算。同时,你也可以将 Flink 处理后的数据写回到其他的数据存储系统中,如 HDFS、HBase、Elasticsearch 等。

是的,Flink 支持将 Kafka 作为数据源,就像将 MySQL 作为源一样。您可以使用 Flink 的 Kafka Source Connector 来读取 Kafka 主题中的数据,并将其用作 Flink 流处理的输入。

Kafka Source Connector 允许您通过消费 Kafka 主题中的消息来构建流式应用程序。您可以使用 Flink 提供的 Kafka Consumer API,以及适当的配置和反序列化策略,从 Kafka 主题中持续读取消息并进行处理。

以下是使用 Flink Kafka Source Connector 的一些示例代码:

在上述示例中,我们创建了一个 Flink 的 Kafka Consumer,并设置了必要的属性,如 Kafka 服务器地址、消费者组 ID 和要读取的主题名称。然后,我们使用

addSource()将 Kafka Consumer 添加到执行环境中,并对每条消息应用相应的处理逻辑(在此示例中,只是简单地打印消息)。最后,我们调用execute()来启动 Flink 作业。需要注意的是,Kafka 是一个流式平台,可以提供实时数据流。但与 MySQL 的 CDC(Change Data Capture)不同,Kafka 本身并不提供直接从源系统中捕获变更数据的功能。如果您希望像 MySQL CDC 那样捕获数据更改并将其传递到 Kafka,您可能需要使用其他工具或库来实现数

kafka直接是流处理,你指的是数据同步到kafka,然后你们再从kafka接入入库吗,

kafka一直都可以作为source,binlog你知道最后赛到哪里才可以让flink读取的吗,像流一样让flink来读,kafka source可以参考https://blog.csdn.net/m0_66705151/article/details/122992610,此回答整理自钉群“Flink CDC 社区”