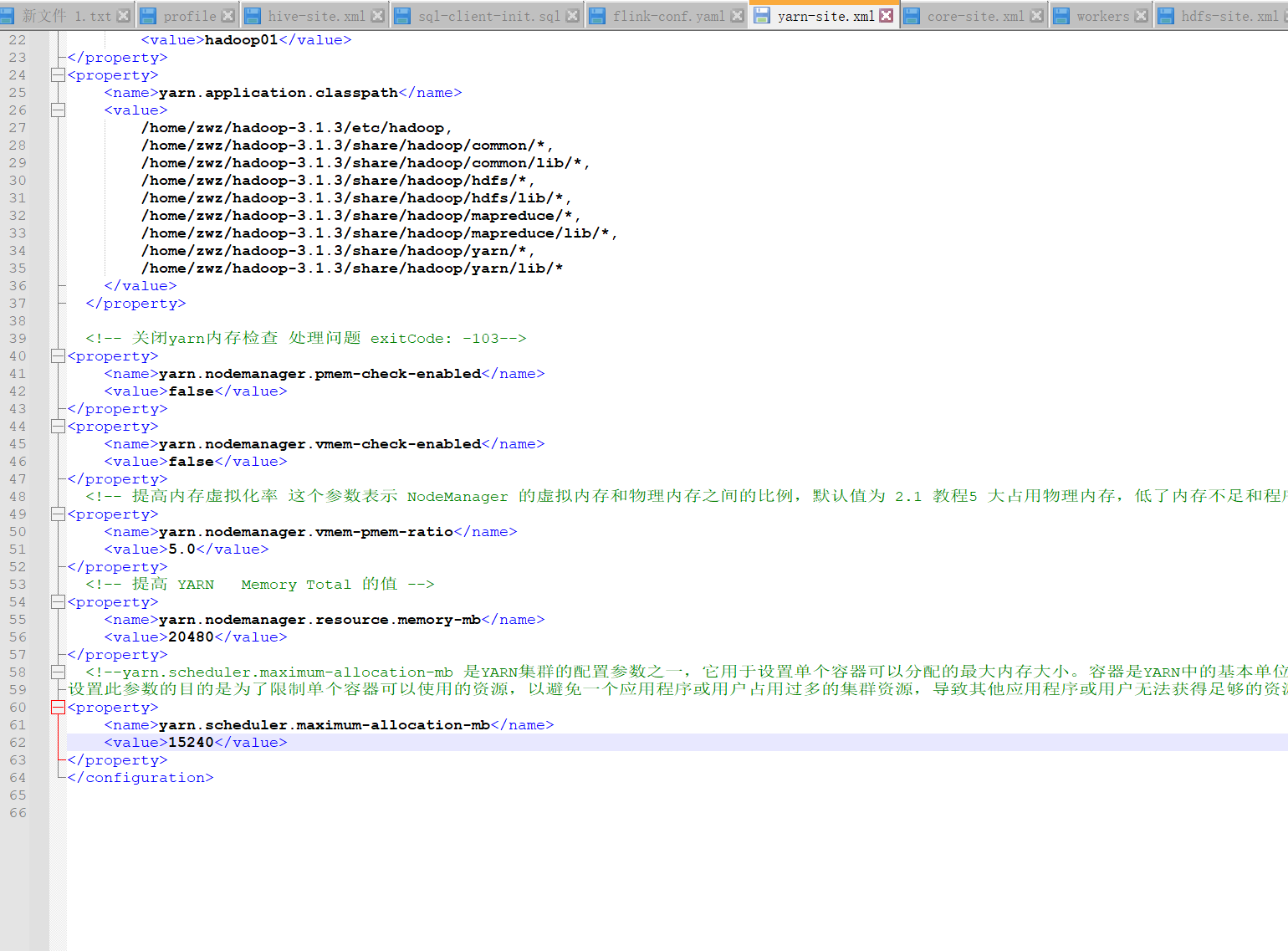

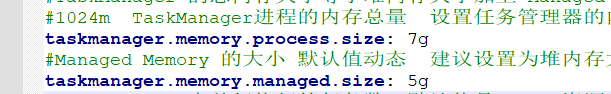

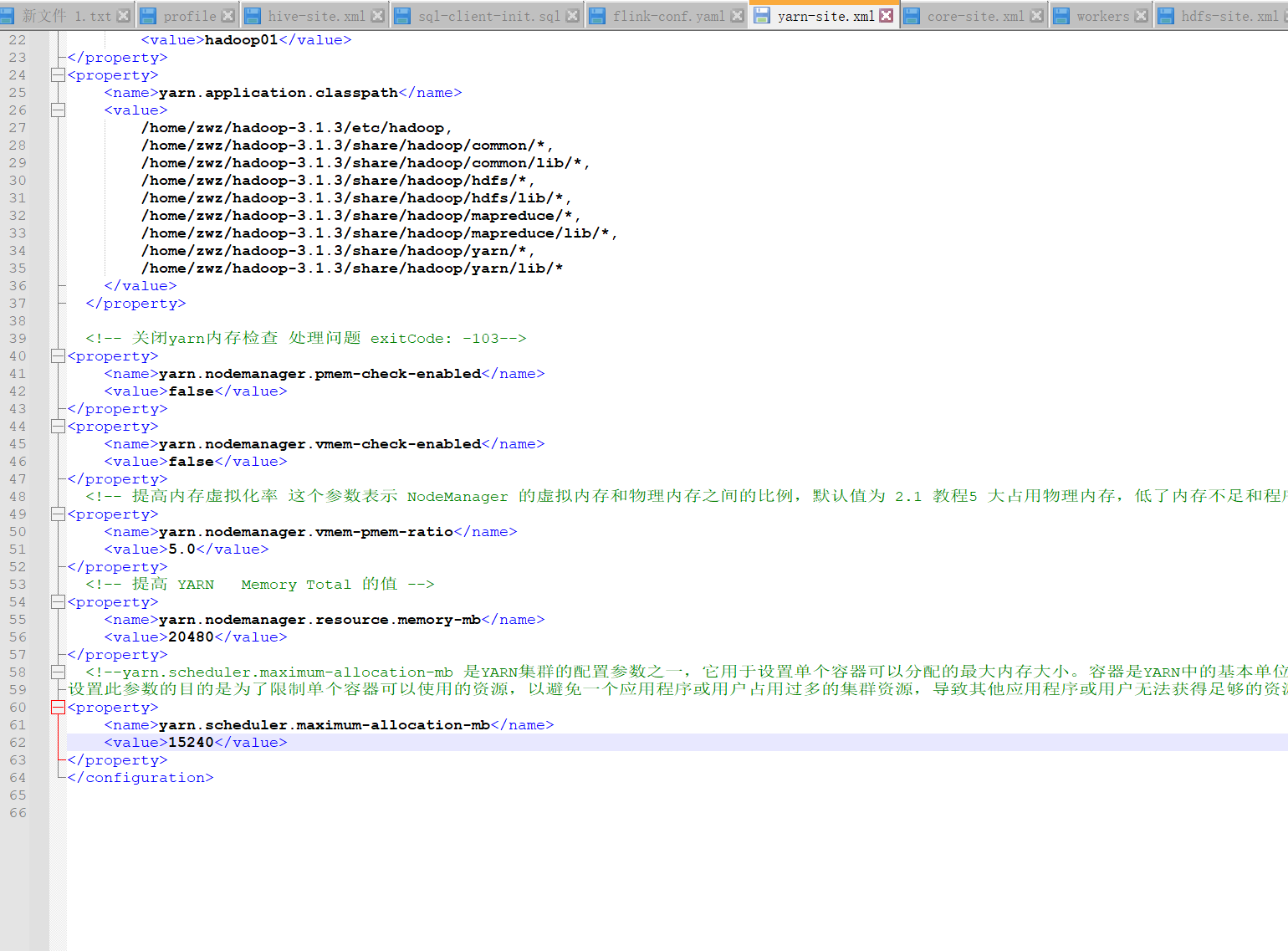

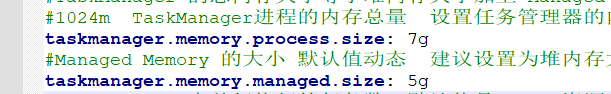

yarn分配了20G内存,flink启动 设置taskmanager.memory.process.size: 7g 启动失败,只能启动6g,是什么限制了我的flink程序内存配置上限呢?

yarn分配了20G内存,flink启动 设置taskmanager.memory.process.size: 7g 启动失败,只能启动6g,是什么限制了我的flink程序内存配置上限呢?

是什么限制了我的flink程序内存配置上限呢?[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

yarn分配了20G内存,flink启动 设置taskmanager.memory.process.size: 7g 启动失败,只能启动6g,是什么限制了我的flink程序内存配置上限呢?

yarn分配了20G内存,flink启动 设置taskmanager.memory.process.size: 7g 启动失败,只能启动6g,是什么限制了我的flink程序内存配置上限呢?

最小slot数是20G/4=5G是上限了,设置为1,还是无法启动, 提示 Derived JVM Overhead size (175.158mb (183666360 bytes)) is not in configured JVM Overhead range [192.000mb (201326592 bytes), 1024.000mb (1073741824 bytes)]. 派生JVM开销大小(175.158mb(183666360字节))不在配置的JVM开销范围[192.000mb(201326592字节),1024.000mb(1073741824字节)]内。可参考链接:https://blog.csdn.net/congcong68/article/details/123852617 此回答整理自钉群“【③群】Apache Flink China社区”

Flink JVM 进程的*进程总内存(Total Process Memory)*包含了由 Flink 应用使用的内存(Flink 总内存)以及由运行 Flink 的 JVM 使用的内存。 Flink 总内存(Total Flink Memory)包括 JVM 堆内存(Heap Memory)和堆外内存(Off-Heap Memory)。 其中堆外内存包括直接内存(Direct Memory)和本地内存(Native Memory)。