问题1:机器学习PAI中jdk是一致的java的jar包提交就没问题python脚本为什么提交就有那个问题?  问题2:这个两边指的是?我们用的是Flink Native Kubernetes模式,把容器内8081端口映射到宿主机8081端口。然后通过命令行提交到宿主机8081端口的,宿主机也需要有java环境,容器内也有。确实是两个Jdk,不过版本和路径在容器内和宿主机上都是一致的。

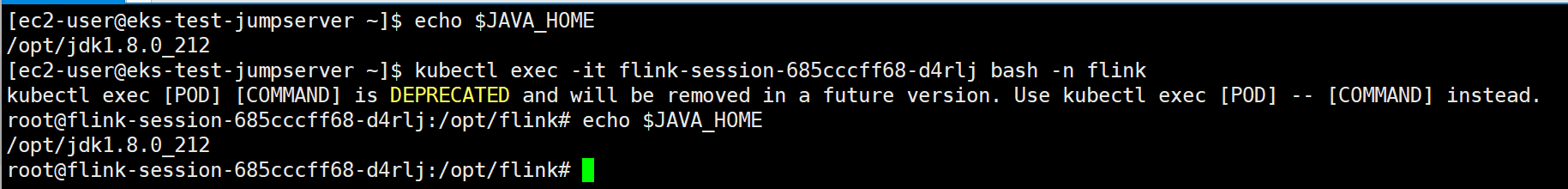

问题2:这个两边指的是?我们用的是Flink Native Kubernetes模式,把容器内8081端口映射到宿主机8081端口。然后通过命令行提交到宿主机8081端口的,宿主机也需要有java环境,容器内也有。确实是两个Jdk,不过版本和路径在容器内和宿主机上都是一致的。  我好像理解了,你说的应该是启动Flink的jdk版本和Python启动时候获取到的版本不一致。我排查一下,那个问题解决了,是提交任务的宿主机上scala版本和镜像里面scala版本不一致导致的。

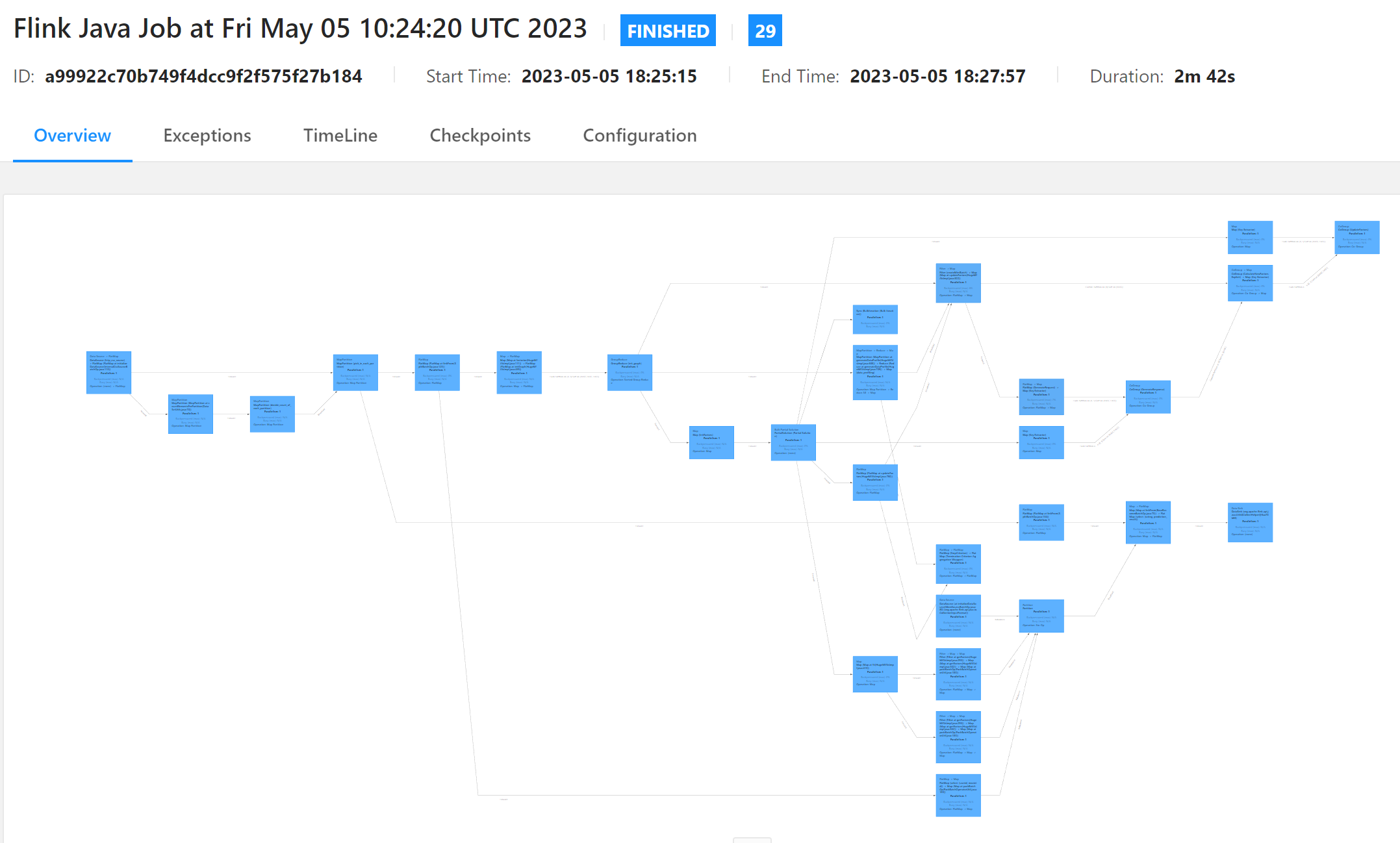

我好像理解了,你说的应该是启动Flink的jdk版本和Python启动时候获取到的版本不一致。我排查一下,那个问题解决了,是提交任务的宿主机上scala版本和镜像里面scala版本不一致导致的。

机器学习PAI中jdk是一致的java的jar包提交就没问题python脚本为什么提交就有那个问题?[阿里云机器学习PAI]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

问题1:Java和Python虽然都跑在JVM上,但是两者用到的库和运行环境可能并不完全一致,这可能导致在Python中出现问题,而Java没有问题。您可以尝试检查在Python脚本中使用的库和运行环境与Java的jar包相同。

问题2:两边指的是Flink集群中的master节点和提交任务的客户机(即您的本地机器)。您的Flink集群使用的是Flink Native Kubernetes模式,因此您需要将客户端的提交命令打向Kubernetes API服务器,然后Kubernetes会启动一个Flink JobManager来管理Flink作业。您的问题可能是由于本地机器上的Scala版本与Flink镜像中的版本不同导致的,因此请确保本地和镜像中的Scala版本一致。

机器学习PAI支持多种不同的应用程序提交方式,包括Java、Python、C++等。在这些不同的提交方式中,可能会有一些具体的差异和特点,需要针对性地进行配置和处理。

由您描述的情况来看,Java的Jar包可以正常提交执行,而Python脚本存在问题,这可能是因为Python环境或相关依赖库没有正确配置导致的。以下是一些可能导致Python脚本提交失败的原因:

Python版本问题:机器学习PAI需要运行的Python应用程序需要依赖于Python环境,如果平台上安装的Python版本与应用程序要求的版本不一致,就可能会导致某些依赖库无法加载或运行错误,从而导致任务提交失败。

依赖库问题:Python应用程序通常需要调用很多第三方依赖库,这些库需要提前安装并配置好。如果应用程序要求的某个依赖库没有正确安装或者版本不一致,也可能会导致任务提交失败。

脚本语法问题:如果Python脚本自身的语法有问题,例如未定义变量、引用不存在的模块或函数等,也可能导致任务提交失败。

环境变量问题:有时候,Python应用程序还需要根据特定的环境变量来加载某些依赖库或执行一些操作,如果这些环境变量没有正确配置,也可能导致任务提交失败。

机器学习PAI平台支持使用Java和Python语言提交作业,但在使用Python脚本提交作业时可能会出现各种问题。其中一个常见的问题是缺少依赖库或者环境不兼容等导致的。

与Java相比,Python的执行环境更加灵活,但也更加复杂。如果您在提交Python作业时遇到了问题,建议您检查以下几个方面:

Python版本:机器学习PAI平台支持多种Python版本,并且每个版本都有对应的依赖库。请检查您使用的Python版本是否与您的代码和依赖库兼容。

依赖库:Python的依赖库安装方式和相互之间的兼容性都比较特殊,请确保您的依赖库已经正确安装,并且能够在机器学习PAI平台上正常使用。

文件路径:在Python脚本中指定文件路径时需要注意,因为机器学习PAI平台会在不同的节点上执行脚本,所以文件路径需要使用相对路径或者绝对路径来确定位置。

输出路径:请检查您的Python脚本输出路径是否正确,并且您有权限写入该路径下的文件。

希望以上信息对您有所帮助。

针对问题一的回答:$JAVA_HOME是一致的么品七,这个错误一般都是jdk不一致,生成id不一致引起的品七,python脚本起的java时在$JAVA_HOME里边的,两边对一下。 针对问题二的回答:提交任务的宿主机上scala版本和镜像里面scala版本不一致导致的。__此回答整理自钉群“Alink开源–用户群”