大数据计算MaxCompute有没有其余方式来实现 我的函数里面有限制?只能并发50去跑这个函数的逻辑

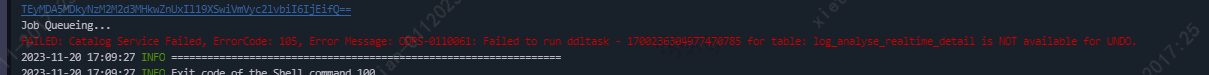

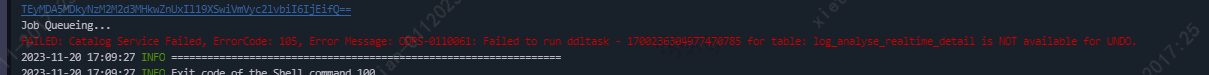

我执行undo table tablename to jobid; 的sql报错了,这是因为原表的分区不存在了吗

大数据计算MaxCompute有没有其余方式来实现 ?[阿里云]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

大数据计算MaxCompute有没有其余方式来实现 我的函数里面有限制?只能并发50去跑这个函数的逻辑

我执行undo table tablename to jobid; 的sql报错了,这是因为原表的分区不存在了吗

没有这样的参数让资源一直保持一个数量级,此回答整理自钉群“MaxCompute开发者社区2群”

如果您希望限制某个函数的并发执行数量为50,大数据计算MaxCompute本身并没有直接提供这样的功能。但是,您可以通过一些方式来实现类似的限制:

自定义任务调度:您可以编写一个自定义的任务调度程序,用于管理并发执行的任务数量。该调度程序可以维护一个任务队列,并控制同时执行的任务数不超过50。当有新的任务需要执行时,将其加入队列,同时检查是否已达到并发限制。如果未达到限制,可以启动新的任务进行处理。

数据分片和多个作业:如果您的输入数据可以进行切片或分片处理,可以将数据切分为多个部分,并创建多个MaxCompute作业来处理每个部分。通过设置合适的并发度和资源配置,确保总并发数不超过50。

调用第三方调度工具:您可以使用第三方的任务调度工具,如Apache Airflow、Apache Oozie等,来管理任务的调度和并发执行。这些工具通常支持任务依赖关系和并发控制等功能,您可以根据需求配置任务的调度策略。

请注意,以上方法都需要额外的开发和配置工作,并且可能会增加系统复杂性。建议在实施之前充分评估和测试所选方法的可行性和适用性,以确保满足您的并发限制需求。