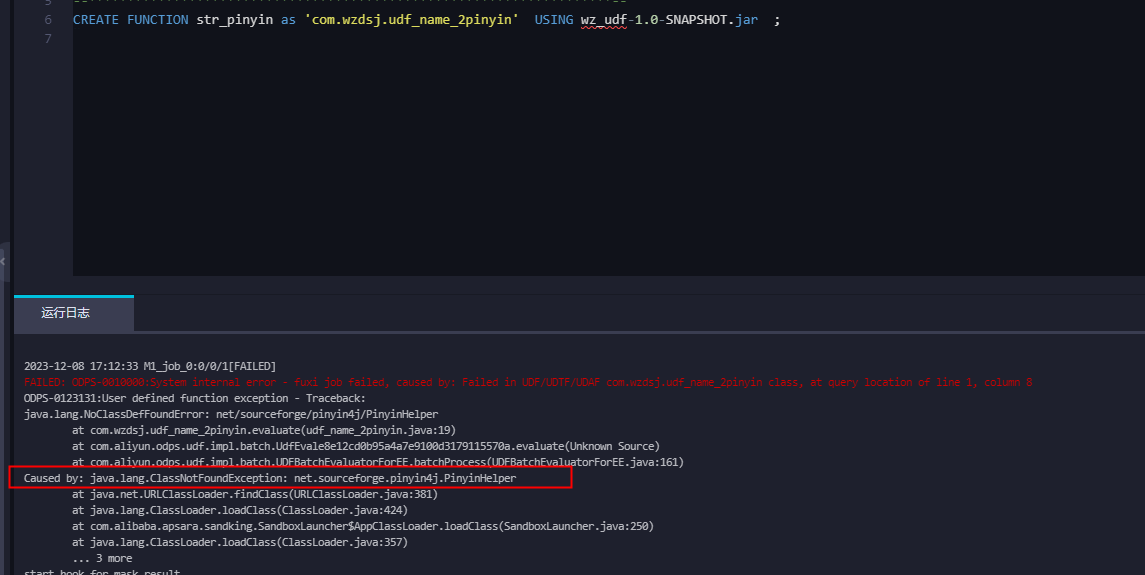

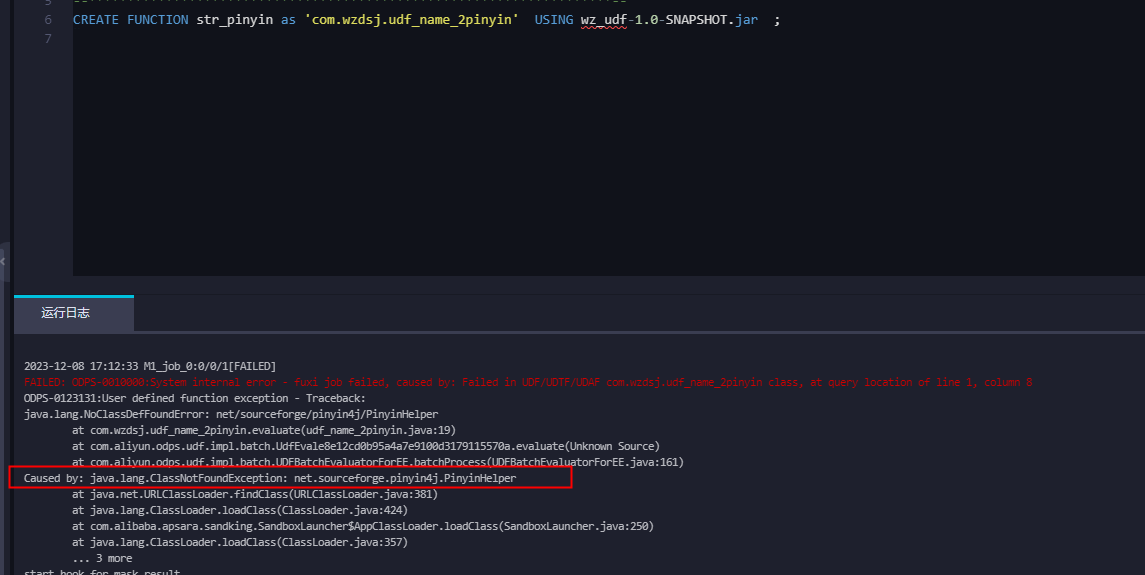

问下大数据计算MaxCompute,自定义udf的函数,引用了import net.sourceforge.pinyin4j.PinyinHelper;但是上传资源后,报错:

Caused by: java.lang.ClassNotFoundException: net.sourceforge.pinyin4j.PinyinHelper

问下大数据计算MaxCompute,上传资源后,报错,什么原因?[阿里云]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

问下大数据计算MaxCompute,自定义udf的函数,引用了import net.sourceforge.pinyin4j.PinyinHelper;但是上传资源后,报错:

Caused by: java.lang.ClassNotFoundException: net.sourceforge.pinyin4j.PinyinHelper

这个问题可能是因为在MaxCompute中,自定义的UDF函数引用了

net.sourceforge.pinyin4j.PinyinHelper这个类,但是该类没有被正确地打包到你的项目中。解决这个问题的方法是:

pinyin4j库添加到你的项目依赖中。如果你使用的是Maven,可以在pom.xml文件中添加以下依赖:如果你使用的是其他构建工具,如Gradle,请确保你也添加了相应的依赖。

如果你已经添加了依赖,但仍然出现问题,那么可能是IDE的问题。尝试重启IDE或者清理并重新构建项目。

如果以上方法都无法解决问题,你可以尝试将

pinyin4j库手动下载到本地,然后将本地的jar文件添加到项目的类路径中。错误2: https://help.aliyun.com/zh/maxcompute/user-guide/odps-0123031?spm=a2c4g.11186623.0.i121

java.lang.ClassNotFoundException:com.aliyun.odps.hive.wrapper.HiveInputFormatWrapper

错误信息示例

ODPS-0123131:User defined function exception – internal error – Fatal Error Happended

java.lang.RuntimeException: java.lang.ClassNotFoundException: com.aliyun.odps.hive.wrapper.HiveInputFormatWrapper

错误描述

使用到了hive相关的解析器,但没有打开hive兼容开关,导致报错。

解决方案

设置以下参数打开hive兼容模式:

set odps.sql.hive.compatible=true;