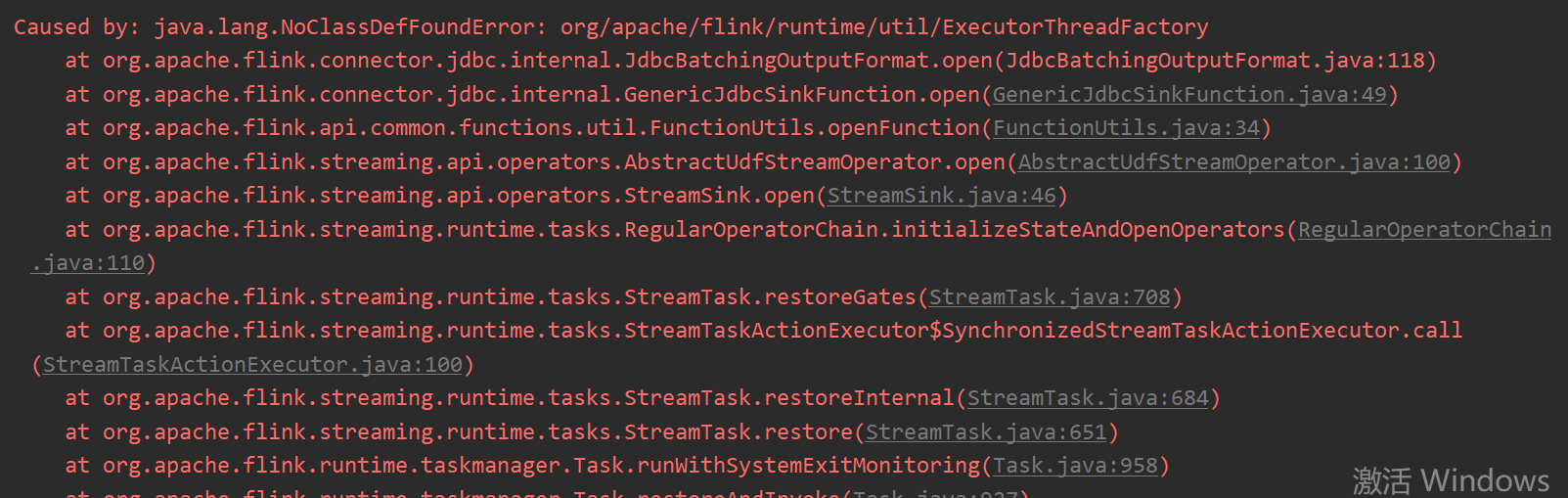

问题1:flink1.14.6 用jdbc connector 报这样的错,各位大佬有遇到过吗? 问题2:其实主要是在插入mysql环节报这个错,使用flink sql 方式,没有报任何错,但是mysql里面没数据;使用flink DataStream方式的connector 就报这样的错,如果是版本冲突的话,我从哪下手查呢,我是从mysql读数据,然后写入另一个表,可以读出来数据,但是写不进去

问题2:其实主要是在插入mysql环节报这个错,使用flink sql 方式,没有报任何错,但是mysql里面没数据;使用flink DataStream方式的connector 就报这样的错,如果是版本冲突的话,我从哪下手查呢,我是从mysql读数据,然后写入另一个表,可以读出来数据,但是写不进去

flink1.14.6 用jdbc connector 报这样的错,各位大佬有遇到过吗?[阿里云实时计算 Flink版]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

对于您的问题,报错信息有点模糊,但可能的原因如下:

问题1:flink-connector-jdbc 报错 – 缺少 flink-connector-jdbc 相关依赖:请确保您的项目中引入了 flink-connector-jdbc 和 flink-sql-connector-jdbc 等相关依赖,并且版本与 Flink 1.14.6 匹配。 – 依赖版本不匹配:请确保 Flink 和 flink-connector-jdbc 的版本一致。可以尝试升级或降级 flink-connector-jdbc 的版本来解决冲突。 – 类加载路径问题:检查类加载路径是否正确包含了 flink-connector-jdbc 的 JAR 包。

问题2:插入 MySQL 报错 – 依赖版本不匹配:确保 flink-connector-jdbc 的版本与 Flink 一致。 – 数据库连接配置错误:检查您的连接字符串、用户名和密码等数据库连接配置是否准确。 – 网络问题:检查网络连通性,确保可以正常访问 MySQL 数据库。 – 依赖作用域设置错误:检查 Maven 依赖是否正确设置,以确保 flink-connector-jdbc 被正确引入。

在解决问题时,您可以逐个排除这些可能的原因。同时,查看日志文件可能会提供更多详细的错误信息,有助于定位问题的根本原因。

这可能是以下几个原因造成的:

flink-connector-jdbc相关依赖缺失

需要确保你的项目中引入了如下依赖:

flink-connector-jdbc

flink-sql-connector-jdbc

flink-connector-base_2.13 等

依赖版本不匹配

Flink 和 flink-connector-jdbc 的版本必须保持一致。

类加载路径有问题

需要检查你的类加载路径(classpath)是否正确包含了flink-connector-jdbc的jar包。

网络问题,无法下载相关依赖

请检查项目是否能访问外网,以下载相关的依赖。

依赖作用域设置有误

请检查你依赖flink-connector-jdbc的方式,如maven依赖是否设置正确。

具体来说,需要如下maven依赖:

xml

Copy

org.apache.flink

flink-connector-jdbc_2.12

1.14.0

org.apache.flink

flink-sql-connector-jdbc_2.12

1.14.0

希望以上信息能为你定位

回答1:看下依赖的jar版本 是否有冲突问题 回答2:sql和 DataStream connector 是两个不同的jar依赖,此回答整理自钉群“Flink CDC 社区”