请教个大数据计算MaxCompute问题 reducers输入数据是8条 吧 set odps.stage.num=10 没有每个work一条数据二十分配不均匀的有的1有的 2 但是如果 set odps.stage.num=100 就会每个work一条

有办法强制平均分配吗?

请教个大数据计算MaxCompute问题 有办法强制平均分配吗?[阿里云MaxCompute]

「点点赞赏,手留余香」

还没有人赞赏,快来当第一个赞赏的人吧!

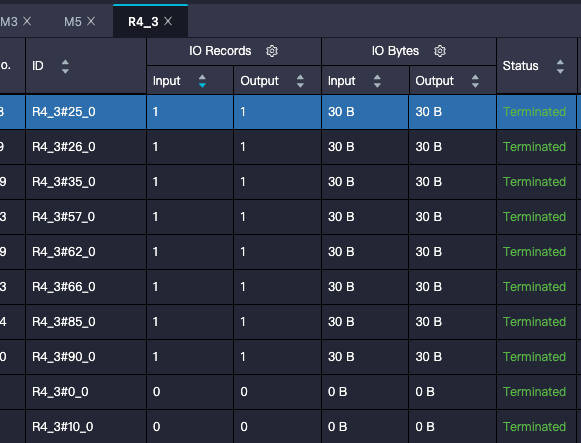

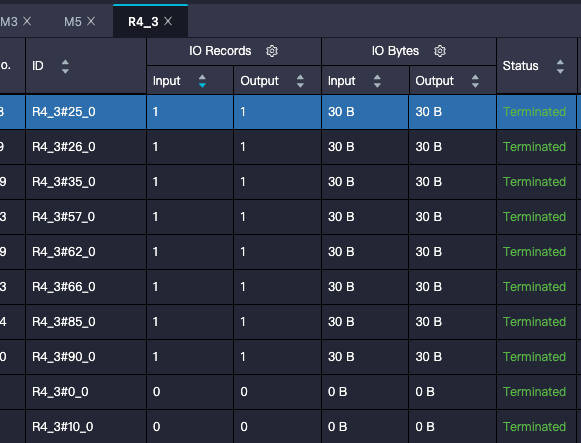

请教个大数据计算MaxCompute问题 reducers输入数据是8条 吧 set odps.stage.num=10 没有每个work一条数据二十分配不均匀的有的1有的 2 但是如果 set odps.stage.num=100 就会每个work一条

有办法强制平均分配吗?

对于你的问题,强制平均分配大数据计算任务,一般而言,可以通过在任务分配策略中设定强制平均分配的规则来实现。具体的实现方式可能会因不同的平台和工具而有所不同。

在MaxCompute中,可以通过设置

odps.stage.num参数来控制MapReduce作业的Stage数量。该参数决定了每个Stage应该处理的数据条数。根据您提供的信息,当将

odps.stage.num设置为10时,每个Stage处理的数据条数不均匀,有的Stage处理1条数据,有的Stage处理2条数据。而当将odps.stage.num设置为100时,每个Stage都处理一条数据。如果您希望强制平均分配数据,可以尝试增加

odps.stage.num的值。通过增加该值,可以增加更多的Stage,从而更有可能实现数据的均匀分配。例如,您可以将odps.stage.num设置为一个更大的值,如1000或更大。请注意,尽管增加

odps.stage.num的值可以提高数据的平均分配性,但并不能保证完全平均分配。因为数据分布的均衡性还受到其他因素的影响,如数据的键值分布、数据倾斜等。因此,在实际使用中,需要根据具体情况进行调整和优化。在MaxCompute中,可以通过set odps.stage.num参数来调整reducer的数量。默认情况下,odps.stage.num等于2,这意味着每个worker机器将有两个reducer任务。

当odps.stage.num设置为10时,总共有八个reducer任务。但是,这并不是说每台worker机器上都有两个reducer任务。相反,reducer任务会被平均分配给各个worker机器,以平衡负载均衡。因此,在不同worker机器上的reducer任务数量可能存在差异。

要让每个worker机器只有一个reducer任务,可以将odps.stage.num设置为100。这样,所有reducer任务都会分配给一台worker机器,而不是多台机器。

需要注意的是,如果reducer任务过多,可能会导致资源浪费,因为单台机器可能会负担过重。因此,建议根据您的实际需求来设置odps.stage.num。